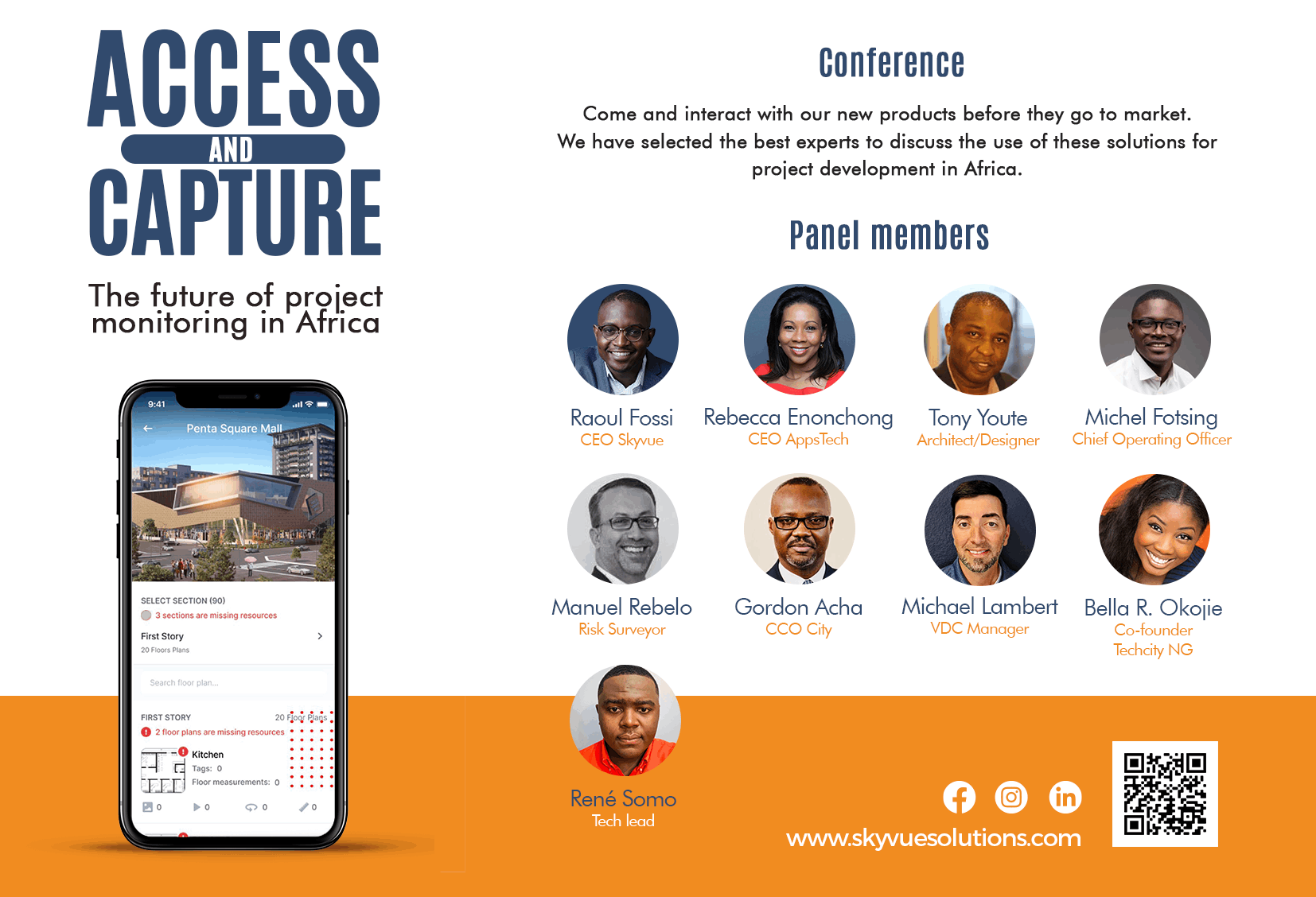

Skyvue solutions

Le Big Data

Qu’est-ce que

le Big Data ?

Disons-le d’emblée : il n’y a pas de définition unanimement partagée de la notion de « Big Data ». Cela ne signifie pas pour autant que Big Data est un terme fourre-tout ou vide. Au contraire, il renvoie à une réalité bien consistante.

Big Data est utilisé pour désigner deux ensembles de choses :

Les grosses bases de données. « Big Data » signifie d’abord « big volume of data ». Dans le Big Data, il y a l’idée qu’on ne gère pas de la même manière des bases de données classiques et des énormes volumes de données. A partir d’un certain seuil, la différence quantitative, volumétrique, se transforme en différence qualitative. Les process et traitements changent de nature. A partir d’un certain seuil, les données ne peuvent plus être gérées de manière classique, dans des bases et des outils classiques. Ce qui nous amène immédiatement au second point.

Les dispositifs informatiques et plus largement les technologies utilisés pour gérer de gros volumes de données. Le Big Data ne renvoie pas qu’aux données en tant que telles, mais aussi aux technologies, aux stratégies, aux techniques utilisées pour gérer de gros volumes de données.

Les entreprises n’ont jamais eu autant de données à leur disposition, mais, pour la plupart, elles ne savent pas quoi en faire, elles n’en exploitent qu’une toute petite partie. Le Big Data, c’est avant tout l’art et la manière de faire un usage efficace de l’énorme volume de données que pratiquement toutes les organisations ont à leur disposition. Le Big Data permet d’exploiter de manière optimale les données à disposition, d’en dégager le maximum d’enseignements (insights) à valeur stratégique, de trouver plus facilement les réponses aux questions que l’on se pose.

Si les problématiques associées au Big Data sont anciennes, ce n’est vraiment que maintenant qu’elles sont devenues impérieuses. Le Big Data devient indispensable pour les grandes entreprises.

Pour mieux comprendre ce qu’est le Big Data et les problématiques qu’il soulève, apportons quelques précisions quant à sa définition. Dans le Big Data, la question du « volume » n’est pas le seul défi.

Définition du

Big Data par les 3 « V »

Les prérequis fondamentaux pour travailler avec des Big Data sont les mêmes que ceux nécessaires pour travailler avec des bases de données classiques. Dans les deux cas, il s’agit de gérer des données : stockage, transformations et traitements divers et variés, BI, activation…Avec le Big Data, nous restons dans le monde plus large du Data Management.

Néanmoins, l’échelle massive des données à

traiter, la vitesse d’ingestion et de processing, les caractéristiques des

données qui doivent être processées à chaque étape de traitement font émerger

de nouveaux challenges technologiques.

L’objectif principal du Big Data est de

réussir à faire apparaître des enseignements (insights) et des connexions entre

de gros volumes de données de nature hétérogène qui seraient impossible à

obtenir avec les méthodes classiques d’analyse des données.

En 2001, Doug Laney, un analyste de chez Gartner, a donné une définition intéressante du Big Data. Pour expliquer ce qu’est le Big Data, il a présenté la théorie des 3 V. C’est un mode de présentation du Big Data simple et efficace. Elle permet de mieux appréhender la définition du Big Data. Selon Doug Laney, le Big Data peut se comprendre à partir de trois notions ayant tous la particularité de commencer par la lettre « V » :

Volume. Un système Big Data se caractérise d’abord par le volume de données en jeu. Un système Big Data traite un volume de données largement supérieur à ce que traitent les bases de données traditionnelles. Ce qui pose un défi technologique : les volumes de données en jeu excèdent les capacités de stockage d’un simple ordinateur, nécessitent des mises en réseau, l’utilisation du Cloud Computing…L’infrastructure IT sous-jacente doit être en mesure d’accueillir, de digérer et de traiter ces gros volumes de data.

Vélocité. Depuis le début, nous insistons sur la problématique du volume. Dans Big Data, il y a évidemment « Big ». Mais dans le Big Data, le volume n’est pas le seul sujet. Un système Big Data, c’est aussi un système dans lequel la donnée circule vite entre les outils, les bases, les applicatifs, les sources. Les données arrivent dans le système en provenance de sources multiples et sont processées souvent en temps réel pour générer des insights et mettre à jour le système. Dans le Big Data, l’approche orientée « batch » tend progressivement à céder sa place au streaming de données en temps réel ou quasi-temps réel. Dans certains cas d’usage du Big Data, le temps réel ou le quasi temps-réel sont nécessaires.

Variété. Les données sont en grand nombre et circulent vite dans le système. Mais ce n’est pas tout. Le Big Data se caractérise aussi par l’immense variété des données traitées. Les bases de données relationnelles ont affaire à des données structurées, bien définies, bien classées, bien normées. Un Data Warehouse organise de manière structurée des données structurées. Dans le Big Data, les données sont dans leurs majorités non-structurées ou semi-structurées. C’est pour cette raison que Big Data rime davantage avec Data Lake qu’avec Data Warehouse.

En résumé, le Big Data est l’art de gérer de gros volumes de données, complexes et hétérogènes, pour la plupart non structurées, qui doivent circuler vite dans un système donné. Ce n’est pas possible avec les technologies classiques de gestion de données. C’est pour cette raison qu’une définition du Big Data ne doit pas simplement se concentrer sur les données, leur volume, leur format, mais aussi sur les technologies qui rendent possible les traitements Big Data.

Certains auteurs ou éditeurs de logiciels ont voulu ajouter d’autres « V » aux trois proposés par Gartner, pour mettre en avant d’autres défis posés par le Big Data :

Véracité. La variété des sources et la complexité des traitements peuvent poser des problèmes en ce qui concerne l’évaluation de la qualité des données (et, in fine, la qualité des analyses faites à partir d’elles). La problématique de la Data Quality est structurante dans n’importe quel projet Big Data.

Variabilité. La variabilité des données

entraîne une variation de leur qualité. Le fait que les données évoluent dans

le temps peut entraîner une dégradation de leur qualité. Dans un système Big

Data, il est important d’avoir à disposition des outils permettant

d’identifier, de traiter et de filtrer les données de faible qualité pour en

optimiser l’utilisabilité.

Valeur. Le défi ultime du Big Data est de créer de la valeur. Or, parfois, les systèmes et les procédures en place sont si complexes qu’il devient difficile d’extraire de la valeur des données à disposition (d’en dégager des insights). La valeur rappelle la finalité business de tout projet Big Data – cette finalité business peut être atteinte directement (programmes & scénarios relationnels basés sur le Big Data) ou indirectement (via les analyses de BI).

Histoire du Big

Data

Bien que le concept de Big Data soit relativement nouveau, les grands ensembles de données remontent aux années 60 et 70, lorsque le monde des données commençait à peine à démarrer avec les premiers datacenters et le développement de la base de données relationnelle.

En 2005, on assista à une prise de

conscience de la quantité de données que les utilisateurs généraient sur

Facebook, YouTube et autres services en ligne. Hadoop (une infrastructure open

source créée spécifiquement pour stocker et analyser les jeux de Big Data) fut

développé cette même année. NoSQL commença également à être de plus

en plus utilisé à cette époque.

Le développement d’infrastructures open

source telle que Hadoop (et, plus récemment, Spark) a été primordial pour la

croissance du Big Data, car celles-ci facilitent l’utilisation du Big Data et

réduisent les coûts de stockage. Depuis, le volume du Big Data a explosé. Les

utilisateurs continuent de générer des quantités phénoménales de données, mais

ils ne sont plus désormais les seuls.

Avec l’avènement de l’Internet of Things

(IoT), de plus en plus d’objets et de terminaux sont connectés à Internet,

collectant des données sur les habitudes d’utilisation des clients et les

performances des produits. L’émergence du machine learning a produit

encore plus de données.

Alors que le Big Data a fait beaucoup de

chemin, son utilité commence à peine à se faire sentir. Le Cloud computing a

encore décuplé ses possibilités. Le cloud offre une évolutivité considérable,

les développeurs peuvent simplement faire fonctionner rapidement des clusters

dédiés pour tester un sous-ensemble de données. Les bases de données

graphesgagnent elles aussi en importance, car elles permettent d’afficher des

quantités massives de données d’une manière qui rend l’analyse rapide et

complète.

Les défis liés

au Big Data

Si le Big Data ouvre des perspectives intéressantes, il n’en présente pas moins certains écueils.

Premièrement, le Big Data est… volumineux. Même si de nouvelles technologies ont été mises au point pour le stockage des données, les volumes de données doublent environ tous les deux ans. Les entreprises éprouvent toujours des difficultés à maîtriser leur croissance et à trouver des moyens de les stocker efficacement.

Mais il ne suffit pas de stocker les

données. Pour être utiles, celles-ci doivent être exploitées et, en amont,

organisées. Des données propres, ou des données pertinentes pour le client et

organisées de manière à permettre une analyse significative, nécessitent

beaucoup de travail. Les spécialistes des données passent 50 à 80 % de

leur temps à organiser et à préparer les données avant leur utilisation.

Enfin, la technologie du Big Data évolue

rapidement. Il y a quelques années, Apache Hadoop était la technologie la plus

utilisée pour traiter le Big Data. Puis, Apache Spark fit son apparition en

2014. Actuellement, l’association des deux infrastructures semble constituer la

meilleure approche. Maîtriser la technologie du Big Data est un enjeu continu.

Fonctionnement

du Big Data

Le big data permet de relever un immense défi technologique : stocker une grande quantité de données provenant de différents canaux sur un immense disque dur, facilement accessibles depuis les quatre coins de la planète. Des données stockées en lieu sûr et récupérables à tout moment en cas d'incident quelconque.

Pour y parvenir, les fichiers sont découpés

en plusieurs fragments nommés « chunks ». Ces fragments sont ensuite répartis

sur plusieurs ordinateurs, et il existe différentes façons de les reconstituer.

Une panne survient ? Une autre machine vient prendre le relais en empruntant un

autre chemin. Ainsi, les différentes pièces du puzzle restent disponibles en permanence,

et peuvent être assemblées d'une façon ou d'une autre.

La duplication massive des données est

l'une des clés de voûte de l'architecture du big data. Le cloud computing, les

supercalculateurs hybrides (high performance computing ou HPC) et les

systèmes de fichiers distribués (DFS ou distributed files system) figurent

parmi les principaux modèles de stockage actuellement disponibles.

Le Big Data offre de nouvelles perspectives, qui ouvrent de nouvelles opportunités et favorisent de nouveaux business models. Son adoption implique trois actions principales :

Quelques cas d’usage du Big Data

Le Big Data est utilisé dans un grand nombre de secteurs ou domaines d’activité. En voici quelques-unes.

Pour SkyVue

Le big data intervient dans l’étude et la collecte de données

notamment dans l’estimation de materiel de notre produit Quantum

|

Développement de produits Des sociétés comme Netflix et Procter

& Gamble utilisent le Big Data pour anticiper la demande des clients.

Elles créent des modèles prédictifs pour de nouveaux produits et services, en

classant les principaux attributs de produits ou services passés et présents

et en modélisant la relation entre ces attributs et le succès commercial de

leurs offres. De plus, P&G utilise les données et analyses émanant de

groupes cibles, réseaux sociaux, marchés test et présentations en

avant-première pour prévoir, produire et lancer de nouveaux produits. Maintenance prédictive Les facteurs permettant de prédire les

défaillances mécaniques peuvent être profondément enfouis dans des données

structurées, telles que l’année, la marque et le modèle de l’équipement,

ainsi que dans des données non structurées couvrant des millions d’entrées de

journal, de données de capteur, de messages d’erreur et de température du

moteur. En analysant ces indications de problèmes potentiels avant que

ceux-ci surgissent, les entreprises sont à même de déployer leur maintenance

de manière plus rentable et d’optimiser le temps de fonctionnement de leurs

pièces et équipements. Expérience client La course aux clients est lancée. Il est désormais

possible d’avoir une meilleure vue d’ensemble de l’expérience client

qu’auparavant. Le Big Data vous permet de rassembler des données provenant de

médias sociaux, de visites Web, de journaux d’appels et d’autres sources pour

améliorer l’expérience d’interaction et maximiser la valeur fournie.

Commencez à proposer des offres personnalisées, à réduire la perte de clients

et à traiter les problèmes de manière proactive. Fraude et conformité En matière de sécurité, il ne s’agit pas

que de quelques pirates informatiques malhonnêtes : vous faites face à

des équipes entières. Les paysages de la sécurité et les exigences de

conformité sont en évolution constante. Le Big Data vous aide à identifier

des modèles dans les données qui indiquent une fraude et à agréger de grands

volumes d’informations permettant d’accélérer le reporting réglementaire. Machine Learning Le machine learning est un sujet brûlant

en ce moment. Les données, plus particulièrement le Big Data, l’ont rendu

possible. Nous sommes désormais capables d’enseigner aux machines, plutôt que

de simplement les programmer. La disponibilité du Big Data pour former des

modèles de machine learning rend cela possible. Efficacité opérationnelle L’efficacité opérationnelle n’est

peut-être pas toujours l’actualité, mais c’est un domaine dans lequel le Big

Data a le plus d’impact. Grâce au Big Data, vous pouvez analyser et évaluer

la production, les commentaires et retours des clients, ainsi que d’autres

facteurs, afin de réduire les pannes et d’anticiper les demandes à venir. Le

Big Data permet également d’améliorer la prise de décision, en adéquation

avec la demande du marché. Dynamiser l’innovation Le Big Data peut vous aider à innover en

étudiant les interdépendances entre les êtres humains, les institutions, les

entités et les processus, puis en déterminant de nouvelles façons d’utiliser

ces informations. Exploiter les informations pour améliorer les décisions

dans les domaines financiers et de planification. Examiner les tendances et

les souhaits des clients pour offrir de nouveaux produits et services. Mettre

en place une tarification dynamique. Les possibilités sont infinies. |